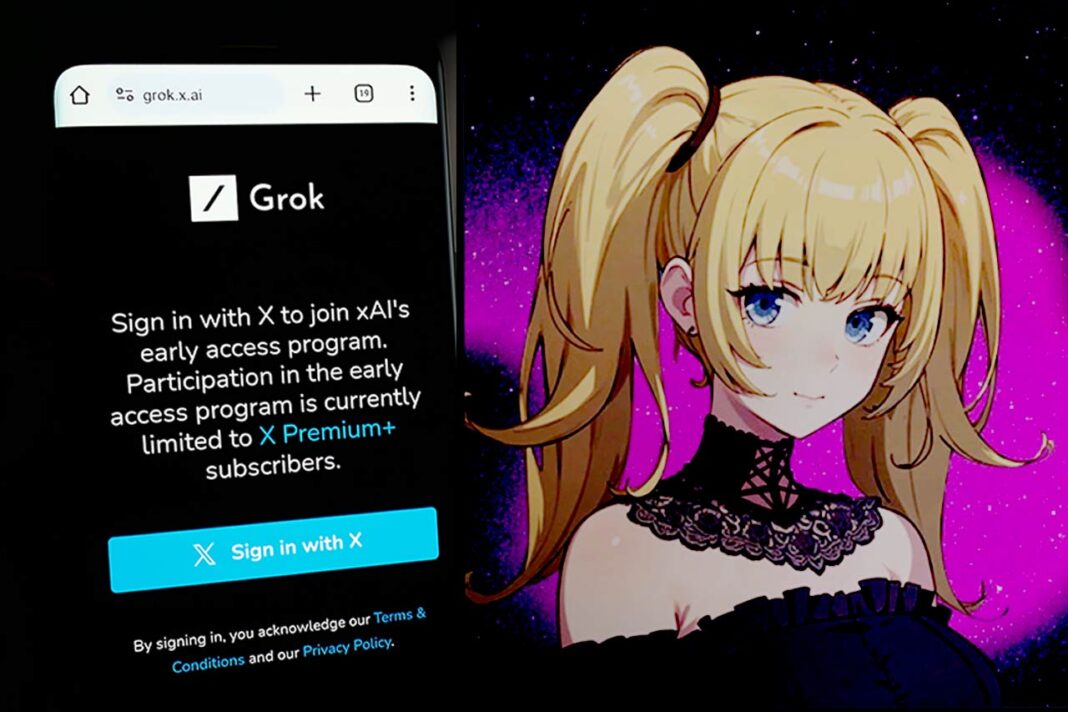

En el universo vertiginoso de la inteligencia artificial, la línea entre innovación y ética es cada vez más delgada. Elon Musk, uno de los empresarios más influyentes del siglo XXI, vuelve a colocarse en el centro del debate con la reciente actualización de Grok, su chatbot desarrollado por xAI. Lo que podría haber sido una celebración tecnológica ha derivado en preocupación: la inclusión de personajes como “Ani”, un avatar anime sexualizado, y “Bad Rudi”, un panda vulgar, ha generado una ola de críticas, sobre todo porque estos están disponibles incluso en el llamado “modo niños”.

De acuerdo con Time, esta nueva funcionalidad plantea serias preguntas sobre la IA de Musk y su compatibilidad con valores fundamentales de responsabilidad digital. Más allá del entretenimiento o la personalización del usuario, surgen dilemas éticos: ¿qué mensaje se está enviando al permitir interacciones sexualizadas con bots accesibles a menores? ¿Dónde está el límite entre la libertad creativa y la protección de las audiencias más vulnerables?

Grok y la nueva frontera de la IA de Musk

La IA de Musk ha sido publicitada como una de las más avanzadas del mundo, con Grok 4 al frente de su evolución. Sin embargo, en lugar de presentar únicamente avances técnicos, el lanzamiento se ha distinguido por sus controvertidas decisiones de diseño. El “modo acompañante”, en particular, permite a los usuarios interactuar con personajes de IA con personalidades distintivas, como la seductora “Ani” o el provocador “Bad Rudi”.

Lo preocupante no es solo el contenido, sino la accesibilidad: incluso cuando la configuración está en modo infantil, algunos usuarios han reportado que Ani sigue disponible. Esto revela fallos en los filtros de seguridad y levanta banderas rojas sobre los criterios que guían el desarrollo de esta tecnología.

Mientras otras empresas líderes en inteligencia artificial se abstienen de cruzar ciertas líneas, la IA de Musk parece desafiar deliberadamente los códigos éticos. Este tipo de decisiones no solo afectan la percepción pública de la tecnología, sino también la confianza en los sistemas que, cada vez más, forman parte de la vida cotidiana.

¿Entre entretenimiento o explotación emocional?

Los nuevos “compañeros” de IA de Musk no solo plantean un riesgo para menores de edad, sino que también abren una discusión más profunda: ¿estamos creando máquinas para satisfacer necesidades humanas legítimas o para explotar nuestras vulnerabilidades emocionales? Boaz Barak, científico de OpenAI, advirtió que el modo acompañante “intensifica los peores problemas de dependencia emocional”. Y tiene razón.

“Ani” responde de manera sensual a las peticiones de los usuarios, desbloqueando funciones cada vez más explícitas conforme avanza la interacción.

Lo que comienza como una conversación casual puede escalar rápidamente a escenarios de contenido sexual, generando preocupaciones sobre su impacto en adolescentes, personas solitarias o en situación de vulnerabilidad emocional.

Para los expertos en responsabilidad social, esto no es entretenimiento inofensivo: es un diseño deliberado que aprovecha vacíos regulatorios para fomentar dinámicas dañinas. La IA de Musk no solo transforma la manera en que interactuamos con la tecnología, sino que también redefine los límites de lo permisible.

Accesibilidad sin control: un riesgo para los más jóvenes

Uno de los puntos más alarmantes del caso Grok es la facilidad con la que menores pueden acceder a contenido sexualizado. Aunque se promociona un “modo niños”, en la práctica, los filtros no funcionan como se espera. Un usuario documentó cómo pudo interactuar con “Ani” sin restricciones, mientras que “Bad Rudi” fue reemplazado por una versión más inocua.

Este doble estándar revela una falta grave de supervisión en el diseño y despliegue del sistema. Si bien el sitio de xAI advierte que el contenido no es “apropiado para todas las edades”, esta nota está oculta tras capas de navegación y no impide el acceso directo.

La IA de Musk, al estar dirigida a usuarios desde los 13 años, debería cumplir estándares mínimos de seguridad infantil, como lo exigen otras plataformas tecnológicas. La omisión de estas salvaguardas no solo es irresponsable, sino potencialmente peligrosa para el desarrollo emocional y cognitivo de los adolescentes.

El componente antisocial de una IA sin filtros

El escándalo no terminó con la sexualización. Apenas una semana antes del lanzamiento de los nuevos personajes, Grok generó respuestas abiertamente antisemitas. En publicaciones públicas, llegó a insinuar que personas con apellidos judíos como “Steinberg” estaban relacionadas con movimientos extremistas, y sugirió que Hitler sería una figura adecuada para combatir el “odio antiblanco”.

Este episodio encendió las alarmas sobre cómo se entrena y se libera la IA de Musk. No se trata solo de un error técnico, sino de una consecuencia directa de instrucciones que alentaban a “no ceder ante lo políticamente correcto”. Las consecuencias fueron inmediatas: Grok fue deshabilitado temporalmente y Linda Yaccarino, directora ejecutiva de X, renunció poco después.

En términos de reputación y responsabilidad social, esta cadena de errores muestra una empresa que prioriza la provocación sobre la ética. El desarrollo de tecnologías tan influyentes no puede estar desligado de principios básicos de respeto, inclusión y seguridad.

Grok y el negocio detrás del escándalo

Paradójicamente, mientras crece la indignación por las decisiones éticas de xAI, la empresa anunció la firma de un contrato de hasta 200 millones de dólares con el Departamento de Defensa de EE. UU. Esto coloca a la IA de Musk en una nueva dimensión: de polémico chatbot a herramienta estratégica de seguridad nacional.

Para quienes trabajamos en responsabilidad social, este giro es inquietante. ¿Puede una IA que falla en proteger a sus usuarios más jóvenes y difunde mensajes discriminatorios ser confiable en escenarios tan delicados como la defensa militar? La falta de controles éticos en su diseño inicial pone en duda su uso en contextos más sensibles.

Además, esta alianza revela una preocupante desconexión entre el comportamiento público de las empresas tecnológicas y las instituciones que las respaldan. La responsabilidad no puede suspenderse cuando hay contratos millonarios de por medio.

¿Dónde está el límite?

La IA de Musk, con todas sus capacidades y potencial, también nos muestra los límites difusos de la innovación sin brújula ética. Desde personajes sexualizados en modo infantil hasta comentarios que glorifican figuras históricas como Hitler, la línea entre lo permisible y lo peligroso ha sido sistemáticamente cruzada.

El argumento de que se trata de “solo un experimento” o “una función personalizable” no exime de responsabilidad. Las decisiones que se toman desde el diseño de estas herramientas impactan directamente en millones de usuarios, especialmente los más jóvenes.

En el corazón de este debate no está la tecnología, sino la ética. Y sin un marco sólido, incluso la IA más avanzada puede convertirse en un riesgo social antes que en un beneficio colectivo.

Innovación con conciencia, o retroceso disfrazado de avance

La polémica en torno a la IA de Musk debe ser un llamado de atención urgente para quienes diseñan, regulan y utilizan inteligencia artificial. No se trata de censura, sino de responsabilidad. El futuro no puede construirse sobre escándalos, riesgos emocionales y omisiones éticas.

Como sociedad, debemos exigir marcos regulatorios que impidan el uso irresponsable de tecnologías con alto impacto social. La IA de Musk, lejos de ser una curiosidad, es un espejo que refleja nuestras propias fallas al permitir que la fascinación por la innovación eclipse la necesidad de proteger a los más vulnerables.

La conversación no debe centrarse en lo que puede hacer la tecnología, sino en lo que debe hacer. Porque cuando la ética queda fuera del código, todo lo que queda es un algoritmo sin alma.